Was geschieht eigentlich auf Seiten der „Leser:innen“ in Sachen Sprachmodelle und Generative AI hinsichtlich Journalismus und Publishing? In der Branche selbst geht es vornehmlich um Aspekte der Produktion: Also wie können große Sprachmodelle (LLM) in der redaktionellen Arbeit eingesetzt oder Veröffentlichungsschritte automatisiert werden. Einen guten Überblick zum Stand der Dinge dabei findet sich hier: Generative KI im Journalismus: Zwischenfazit.

Nur ansatzweise wird sich bislang, so scheint es mir, damit befasst, was auf Seiten der User geschieht. Eine Auswertung von 850 Skizzen (Open Society AI in Journalism Futures-Programmes) zeigte vergangenen Herbst: Der Impact von GenAI auf das Medienökosystem wird sich demnach hinsichtlich des Publikums bei Zugänglichkeit und Verbreitung von Inhalten sowie Personalisierung abspielen.

Nur wie? Weiterhin ist die Darreichungsform von GenAI/LLM für Endverbraucher:innen im Wesentlichen das Chat-Interface. Grundlegend neue Fähigkeiten von Sprachassistenten wie Siri (2026) oder Alexa (unklar) lassen auf sich warten. Co-Piloten und Assistenz-System machen sich zwar in diversen Softwareprodukten breit, doch die Killeranwendung à la Spreadsheets (PC) oder Browser (Internet) für die LLM-Technologie ist noch nicht gefunden. Wobei: Die Bezahlversion von Claude mit seinen Artifacts inkl. Datenauswertung und Projektfunktion hat für mich schon etwas von einer Killeranwendung.

2025, so heißt es vielerorts, würde den Durchbruch für Agentic AI, bringen. Die Hoffnung ist, dass für die LLM-Technologie ein wirkliches Betätigungsfeld und damit ein lukrativer Markt gefunden wird. OpenAI kündigte unlängst an, dass ChatGPT nun „Tasks“ für den User übernehmen kann – etwa regelmäßig eine Website nach einer bestimmten Information checken; ein erster Schritt in Richtung Agentic AI.

Sechs Agenten-Level

Wenn die Agenten kommen, wird es Agentic Media geben. Aber zuerst: Was wird eigentlich unter „Agents“ verstanden?

Sprachmodell-Hersteller Antrophic(Claude) schrieb:

“… are systems where LLMs dynamically direct their own processes and tool usage, maintaining control over how they accomplish tasks.”

Forscher:innen von Google formulierten es jüngst so:

“ a Generative AI agent can be defined as an application that attempts to achieve a goal by observing the world and acting upon it using the tools that it has at its disposal.”

Entwickler-Silberrücken Simon Willis zeigt sich hinsichtlich Agents in seinem umfassenden Jahresrückblick Things we learned about LLMs skeptisch; Sprachmodelle seien zu „leichtgläubig“ (sprich manipulierbar). Deswegen sei die Vorstellung, auf ihrer Basis autarkes Handeln zu organisieren, fragwürdig.

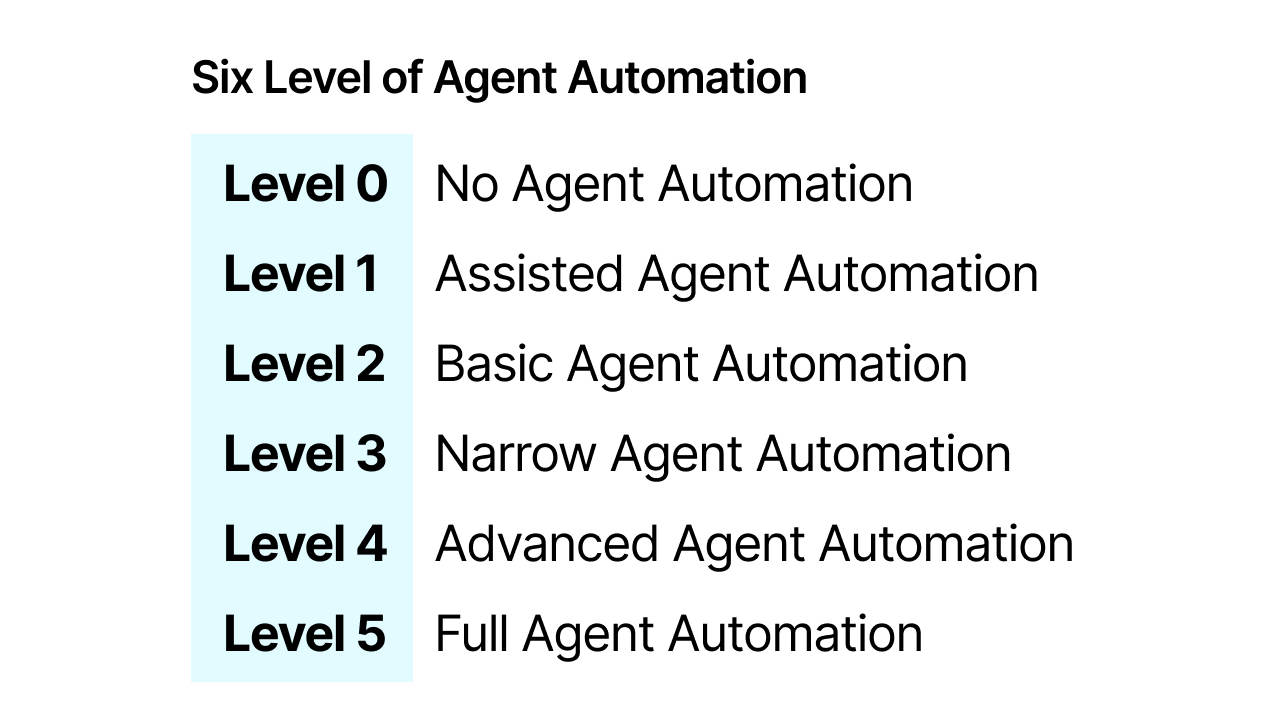

Vielleicht kann ein Level-Modell helfen, angelehnt an die sechs Level des autonomen Fahrens:

Level 0 – No Agent Automation: Der Mensch führt alle kognitiven und entscheidungsrelevanten Aufgaben aus.

Level 1 – Agent Assistance: Kann entweder die Entscheidungsfindung oder die Ausführung einer Aufgabe automatisieren, aber nicht beides.

Level 2 – Basic Agent Automation: Kann sowohl die Entscheidungsfindung als auch die Ausführung bestimmter Aufgaben übernehmen.

Level 3 – Narrow Agent Automation: Kann vollständige Aufgabenzyklen innerhalb enger definierter Domänen selbständig durchführen, braucht aber immer wieder menschliche Eingriffe.

Level 4 – Advanced Agent Automation: Völlig autonomer Betrieb innerhalb bestimmter Bereiche.

Level 5 – Full Agent Automation: Autonomer Betrieb in praktisch unbegrenzten Bereichen (de facto wäre das dann AGI (Artificial General Intelligence)).

Im Grunde geht es um den Grad des automated decision making, der automatisierten Entscheidungsfindung vs. Einbindung des Menschen. In anderen Sektoren sind agentische Systeme längst im unterschiedlichen Grad üblich; siehe etwa Credit Scoring (Schufa & Co, Level 2), Waffensysteme (Lenkraketen, Level 3), Medizin (Bilddiagnostik, Level 3) und Finanzwirtschaft (High Frequency Trading, Level 4). Hinsichtlich „AI“ bewegen sich Programmieragenten (Replit, V0, bolt.new, Lovable usw.) auf Level 3.

Private Gatekeeper

Agentic Media, so fasst es ein aktuelles Projekt an der Uni Siegen eben diesen Namens,

„are conceptualized as semi-autonomous synthetic actors that are cooperatively produced, supported and stabilized in heterogeneous, multiply situated and distributed media and data practices.“

Konzentrieren wir uns dabei auf den Publikumsbereich von Agentic Media, sehe ich derzeit drei relevante Bereiche dieser „semi-autonomous synthetic actors“, die sich bald auf oben skizzierten Level 3 und absehbar Level 4 bewegen dürften.

Privates Gatekeeping & Recherche

Durch das WorldWideWeb verschob sich das Monopol des Filterns und der Wiedergabe eines Abbildes der Wirklichkeit weg von den Verlagen, Sendern und anderen Gatekeepern (One-to-many). Sie kontrollierten die bisherigen Veröffentlichungswege und verloren das Privileg und die Werbeeinnahmequellen an Suchmaschinen und Plattformen, die nun Filterung sowie Sortierungen bestimmten (per „Algorithmen“, Many-to-many). Die nunmehr kostengünstigen Möglichkeiten, mit multimodalen GenAI-Systemen in vielen Sprachen Text, Bild/Video und Ton zu erzeugen, wird das herkömmliche WWW so aufblähen, dass klassische Suchmaschinen und viele Plattformen geflutet werden dürften(„Slop“). Wie lange werden Wissensräume wie Wikipedia einem unermüdlichen flexiblen maschinellen Ansturm standhalten können?

Agentische Mediensysteme werden auf den Geräten der User das Filtern der Inhalte, die dort eintreffen, regeln (Many-to-one). Dabei wird deren Ausgestaltung von Herstellern wie etwa Apple im iOS-Betriebssystem verankert, von Dienstleistern mit eigenen Produkten vorgenommen oder durch offene Systeme, die dem User hohe Ausgestaltungsmöglichkeiten lassen. Denkbar sind die Ausweitung der Funktionen von Messengern, neue Generationen von Browsern oder andere Clients (Feed-Reader, Pocket, Tweetdeck etc.), die ähnlich wie Spamfilter und Adblocker die eintreffenden Inhalte auf Plausibilität und Faktizität prüfen. Durch eigene Verfahren oder dazugeschaltete (eingekaufte) Dienste. Dafür werden diese Systeme auch aktiv ins Web gehen, Sendungen und Livestreams „hören“ und „schauen“ sowie an Schnittstellen (API) herantreten, um Recherche zu betreiben – eigenständig oder im Auftrag des Users. Die Automatisierung der Leser:innen wird das Geschäftsmodell vieler Verlage pulverisieren (dazu mehr in Teil 3).

Die Balkanisierung der Wirklichkeit geht einher mit der Personalisierung der Wirklichkeit – die Qualität ihres Abbilds dürfte noch mehr vom Geldbeutel abhängen als sie in Zeiten von Paywalls und bezahlten Newsletterdiensten usw. eh schon ist. Oder sie ist abhängig vom Grad der eigenen Medienkompetenz und des technologischen Vermögens (wie heute auch schon). Ob zivilgesellschaftliche Initiativen oder öffentlich-rechtliche Einrichtungen hier konzeptionell und technologisch mithalten können, wird sich zeigen. Alternativen zu privatwirtschaftlichen und/oder politisch-motivierten Akteuren täten sicher Not.Ad hoc-Formate

Beliebige Text-, Ton- und Spracherzeugung (inklusive Stimmen- und Stilimitation) ist bereits möglich. Angesichts der Fortschritte von GenAI bei 3D-Grafik- und Videoerzeugung dürfte es nur eine Frage der Zeit sein, bis User in Echtzeit viele Inhalte beliebig variabel als personalisierte, lineare und interaktive Formate konsumieren. Das dürfte vor allem in den Unterhaltungsmedien eine Rolle spielen. Doch wird es eben auch hinsichtlich von Informationsvermittlung relevant: NotebookLLM von Google zeigte das im vergangenen Jahr auf durch seine automatisieren Podcasts; zum Jahresende wurde dessen Funktion erweitert: Der User kann sich nun aktiv verbal in die Diskussion mit den generierten Hosts einschalten. Warum noch Politik-Talkshows schauen, wenn ich selbst mit Imitaten von Peter Scholl-Latour und Angela Merkel die aktuelle Lage in XYZ diskutieren kann?

Repräsentationen und Imitate

Womit wir schon beim Thema sind: automatisierte Repräsentationen und Imitate von Personen. Sei es die/der Leser:innen selbst, die in den digitalen öffentlichen Raum nur noch ein Agenten-Abbild ihrer/seiner selbst schickt. Oder eben Personen des öffentlichen Interesses neben fiktiven Personen, ggf. auf Basis verstorbener realer Personen. Entstehen hier neue Nachrichtenräume? Welchen Stellenwert wird es haben, wenn ein autorisierter Politik-Influencer-Agent einer Partei diskutiert und Statements abgibt? Wird es High-Frequency-Medien geben, die Agenten schreiben, die nur von anderen Agenten gelesen werden?

Angenommen, wir treten in das Agentic Media-Zeitalter als Nachfolge der Social Media-Ära ein. Sicher ist, es wird noch komplizierter. Wenn die Öffentlichkeit erst im Privaten individuell beim User entsteht – ist das dann noch Öffentlichkeit? Wenn jetzt noch jede:r ihr/sein eigener Tendenzbetrieb ist, was bedeutet das für den demokratischen Diskurs?

Klar ist: Medienmonotoring wird noch schwieriger, ganz zu schweigen von Regulierung. Zwar behandelt der EU AI Act „High-Risk AI Systems“. Doch dürfte es strittig sein, ob Agentic Media als Systeme, die „democratic processes“ beeinflussen, verstanden werden können. Abgesehen davon, dass viel Agentic Media von außerhalb der EU kommen, sich ständig verändern und teilweise als Open Source vorliegen wird.

Allerdings: Ich bin schon gespannt darauf, welche neue Formate kommen und wie neuartige agentische Verlage operieren werden. Die Vorstellung, dass Agentic Media für mich Podcasts und Radio hört, TV und Videos schaut sowie etliche Newsletter usw. scannt – in vielen Sprachen dieser Welt – die finde ich schon knorke. Wenn ein System weiß, was mich interessiert und was ich schon kenne. Das mir hilft, die Medienflut zu bändigen und mich automatisch auf Bemerkenswertes aufmerksam macht. So etwas hätte ich gern und deswegen arbeite ich derzeit genau daran. In Teil 2 dieser Artikel-Serie werde ich das Tool vorstellen.

In Teil 2 wird es um konkrete Beispiele von Agentic Media gehen; in Teil 3 um die Auswirkungen auf Publishing und Geschäftsmodelle